Meta 于近期公布了其高拟真数字人系统“Codec Avatars”的最新研究动态。该系统新增了发型可更换功能,借助对“头部”和“头发”的模块化建模,增强了人物外观的自定义程度与整体逼真感。这一技术进展,无疑会助力 Meta 在虚拟社交领域加速拓展,更多细节有望在 9 月 17 日开幕的 Meta Connect 2025 大会上亮相。

Codec Avatars 是 Meta 自2015 年便开始重点投入研发的核心项目。其目标是通过高度逼真的数字人形象,为用户带来远程“真实陪伴”的沉浸式社交感受。当用户佩戴上具备面部与眼动追踪功能的 VR 头显,系统便能实时渲染出与本人极为相似的虚拟形象,自然呈现表情与眼神互动,被业界视为突破“恐怖谷”效应的关键技术之一。

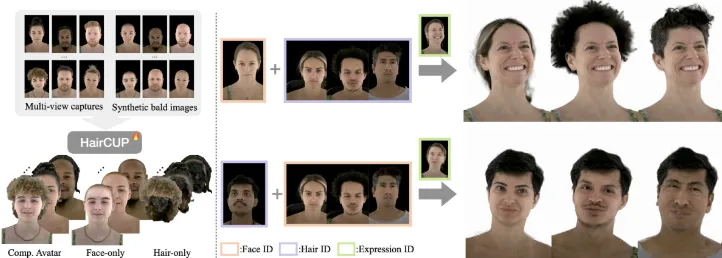

依据 Meta 最新发布的研究论文《HairCUP: Hair Compositional Universal Prior for 3D Gaussian Avatars》,研究团队在高斯渲染(Gaussian Splatting)技术的基础上取得重大突破,首次实现了头发与面部结构的分离建模。这意味着用户无需重新进行人脸扫描WhatsApp网页版,就能自由更换发型。未来,用户既可以从丰富的发型库中挑选预设样式,也能上传自己设计的造型WhatsApp网页版WhatsApp网页版,在保持高还原度的同时充分展现个性。

此外,新技术还着重优化了头发与面部边缘(如发际线、刘海等部位)的融合效果,为后续支持帽子、头饰等头部饰品的搭配奠定了技术基础。

目前,生成一套高质量的 Codec Avatar,用户需先用手机录制自拍视频,然后在高性能服务器 GPU 上处理约 1 小时。虽然 Meta 已构建起“手机端快速采集+云端建模”的完整流程,但系统正式商用仍面临两大阻碍。

当下在售的 Quest 3 与 Quest 3S 均不具备面部或眼动追踪功能,难以驱动 Codec Avatar 的实时表情系统。而此前拥有完整传感器配置的 Quest Pro 已于今年初停产,短期内似乎没有替代型号面世。

尽管苹果 Vision Pro 已能够在设备端本地渲染高斯数字人,但 Meta 头显的硬件性能还不足以支撑高质量 Codec Avatar 的实时运算,目前仍需借助 PC 端 GPU 进行解码与渲染。

业内人士推测,Meta 可能会率先推出 Codec Avatar 的“平面化版本”,应用于 Messenger 与 WhatsApp 等视频通话场景,作为 Meta Avatar 的高拟真替代方案。

尽管 Codec Avatars 距离全面落地还有一段路要走,但 Meta 持续释放技术成果信号,积极推动其从实验室走向产品化。随着用户对沉浸社交、数字化身份以及虚拟共在体验的需求日益增长,该技术有望在未来几年成为 Meta XR 生态的关键组成部分。